Smart Big & Fast Data by HPC

VISION

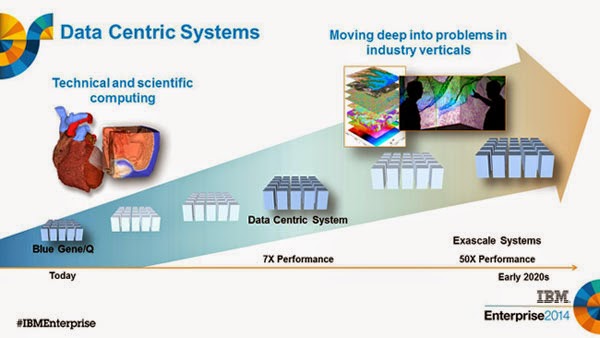

Smart Big & Fast Data by HPC LAB si occupa di ricerca, progettazione e sperimentazione di metodologie di calcolo parallelo e distribuito guidate dai dati, fra i quali, High-Performance Computing (HPC), Edge Computing (EDGE) e High-Performance Data Analytics (HPDA), Distributed Machine Learning (ML).

Nel pieno dell’era digitale, un ecosistema sempre più connesso di dispositivi eterogenei produce sempre maggiori volumi e varietà di dati. Questi dispositivi coprono senza soluzione di continuità l’intera gamma di dimensione, distribuzione e potenza di calcolo che va dai sensori a batteria ai macchinari incredibilmente complicati per scrutare l’origine dell’universo. Per essere utili, questi dati devono essere elaborati, sintetizzati e alla fine trasformati in conoscenza. Alcuni di questi flussi di dati devono essere elaborati molto velocemente perché cambiano velocemente e altrettanto velocemente perdono il loro valore predittivo e operativo oppure perché sono semplicemente troppi per essere memorizzati. Ad esempio, in questa categoria si possono trovare i processi aziendali volatili, i dati relativi ad attività mission-critical, i dati dell’Internet delle cose (IoT) e i dati sperimentali delle grandi sfide scientifiche. Questi dati devono essere elaborati efficientemente e velocemente perché per avere una qualche utilità, qualsiasi previsione sul domani deve assolutamente essere pronta prima di domani.

MISSION

Il laboratorio si occupa di studiare metodi e strumenti per l’elaborazione di dati caratterizzata da necessità di velocità, efficienza, robustezza e dinamicità estrema o comunque superiore a quelle messe a disposizione dalle tecniche standard di elaborazione disponibili off-the-shelf.

CARATTERISTICHE DISTINTIVE

Il laboratorio si presta a fornire competenze specifiche per il calcolo ad alte prestazioni in progetti multi-disciplinari nell’ambito del calcolo parallelo e distribuito finalizzate ad affrontare le necessità di velocità, efficienza, robustezza e dinamicità nell’elaborazione di dati.

Le aziende e gli enti che intraprendono una collaborazione col laboratorio Data-Centric Computing potranno usufruire delle attrezzature hardware e software del Centro di Competenza per il Calcolo Scientifico (C3S) e del centro High-Performance Computing for Artificial Intelligence (HPC4AI) che includono:

- Il cluster ad alte prestazioni OCCAM con oltre 50 nodi di calcolo eterogenei dotati, alcuni dei quali dotati di 768GB RAM e 2 GPU, oltre 1PB di storage.

- Il cloud federato HPC4AI con un totale di oltre 20000 core CPU e 100 GPU specificamente progettato per fornire servizi e risorse per il Big Data Analytics e il Machine Learning.

- Un marketplace per dataset etichettati e applicazioni in ambito Big Data e Machine Learning che facilita il riuso di soluzioni esistenti e la diffusione di nuove applicazioni.

Il laboratorio fornisce competenze per la definizione di nuovi servizi tramite tecniche di design partecipativo, raccolta di requisiti utente, progettazione di nuovi Smart Objects e loro valutazione sul campo.

Membri del team

Marco Aldinucci

Responsabile del laboratorio

Marco Aldinucci – Dipartimento di Informatica

Marco Pironti – Dipartimento di Informatica

Filippo Spiga – Dipartimento di Informatica

Thomas Cocco – Dipartimento di informatica

News

–

Progetti o ricerche innovative

- OptiBike (EU I4MS): Robust Lightweight Composite Bicycle design and optimization, experiment of EU i4MS Fortissimo2 project (2017, 24 months, total cost 230K €).

- HPC4AI (Regione Piemonte, INFRA_P): Turin’s centre in High-Performance Computing for Artificial Intelligence (2018, 24 months, total cost 4.5M €).

- cHiPSet (EC-COST Action IC1406): High-Performance Modelling and Simulation for Big Data Applications (2015, 48 months).

Eventi organizzati

- TBD